最近遇到了个比较BT的网站,限制每个IP每天只能下载50个页面,多余50就会出现block提示信息。即便用30个代理一天也才只能下载1500个页面。 Richard给我推荐了两个解决方案: (1)从Google Cache中读取页面。 (2)利用Google Translation。 我首先尝试了方

阿里巴巴会员信息采集大师V1.0免费版 点击查看详情 软件功能: 采集 阿里巴巴 网站指定分类下的公司信息。可限定行业和区域。采集结果以Excel文件(CSV格式)保存。 采集字段包括:公司名称、分类、 注册年份、注册资金、公司简介、联系人、电话、 传真、移

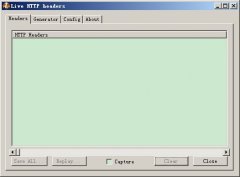

在做Web数据抓取时,偶尔会遇到一些页面进行了Cookie验证,如果爬虫发送的请求头中没有正确的Cookie字段就会导致拿不到正确的页面。 在开始之前,我先介绍一个利器:火狐的抓包插件-Live HTTP headers 如何安装Live HTTP headers(假设你已经安装Firefox了)

# how to deal with unicode problem for screen scrape# by redice 2011.03.04# following example shows how to solve this problemfrom webscraping import download, xpathD = download.Download()url = 'http://www.infobel.com/fr/belgium/mediterrane

开源我的数据抓取模块:sitedigger 欢迎使用,欢迎提出意见或建议! 谷歌代码: http://code.google.com/p/sitedigger/ 版本控制:HG 获取代码拷贝: hg clone https://sitedigger.googlecode.com/hg/ sitedigger

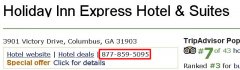

很多网站为了防止用户的隐私信息(电话、手机、邮箱)被爬虫抓取,都对这些信息作了特殊处理。例如,采用JS输出、采用Ajax方式触发后动态加载、以图片的形式显示。其中最常见的就是采用JS输出,这种方法实现的成本最低,同样也最好被抓

很好 。。

呵呵,谢谢

非常好

....................

在unix网络编程中看到了关于TCP/IP的一些内容,我感觉还是写的不够。正在下载中,一定

下载地址呢

谢~~