应用场景: 程序需要运行很长时间,SSH客户端离线不能影响程序运行。 之前一直采用nohup的方法,让程序以守护进程的方式运行。跟人感觉nohup有以下的不足: nohup.out可能占用大量硬盘空间。 SCP,FTP文件上传类需要互式操作的程序用nohup不适合。例如我想用

为了避免占用大量的内存导致服务器进程崩溃,最好采用迭代器的方法,例如程序要产生并输出一个100万行的JSON数据(大约100MB),按照常规的方法,先在内存中准备好这100万行数据,然后输出。

服务器上没有装图形服务(X server),终端下无法运行有GUI的程序。 运行提示:cannot connect to X server :0.0 Xvfb可以虚拟出一个X终端服务,使得在没有安装X Server的机器上也能运行GUI程序。 安装Xvfb:sudo apt-get installxvfb 测试:xvfb-run --serv

需要在Ubuntu下运行一个使用了PyQt4的Python脚本,安装PyQt4的步骤如下: sudo apt-get installpython-qt4 sudo apt-get installpyqt4-dev-tools sudo apt-get installqt4-designer 测试: import sip 无错误提示则sip库安装成功 import PyQt4.QtCore 无错误

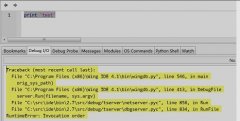

Wing IDE调试任何程序出现如下错误: Traceback (most recent call last): File C:\Program Files (x86)\Wing IDE 4.1\bin\wingdb.py, line 546, in main orig_sys_path) File C:\Program Files (x86)\Wing IDE 4.1\bin\wingdb.py, line 413, in DebugFile s

参考:《DjangoBook2.0》 数据模型高级进阶 经典的例子:一本书有多个作者,一个作者有多本书,典型的多对多关系。 设计模型如下: from django.db import modelsclass Author(models.Model): first_name = models.CharField(max_length=30) last_name = mod

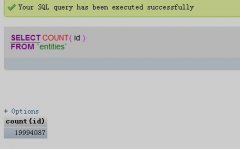

测试了一下MySQLdb的executemany()方法,速度是惊人的:10分钟内插入了100万的数据。赶快来做个标记! 测试环境: Amazon RDS (Amazon Relational Database Service),数据表中原本有1900万条数据,测试完毕后,数据条数如下: 而之前我用execute()逐条插

很不错的技巧,原文在这里: http://djangosnippets.org/snippets/26/ from django import newforms as formsfrom models import Language# I put this on all required fields, because it's easier to pick up# on them with CSS or JavaScript if they ha

我使用了一个名为MongoEngine的封装API,它和Django的ORM很类似。 感觉安装和使用都很方便。 关于MongoEngine的更多资料可以看这里: http://mongoengine.org/ 。 User Guide http://readthedocs.org/docs/mongoengine-odm/en/latest/guide/index.html 一段

1)sudo apt-get install libjpeg-dev 2)sudo apt-get install libfreetype6-dev 3)sudo easy_install PIL 不安装libjpeg-dev,会出现:decoder jpeg not available错误,如下图示。 不安装libfreetype6-dev,会出现The _imagingft C module is not instal

uploadify 是一个flash实现的图片上传客户端,支持批量上传。 服务端支持任何脚本语言(只要写好处理接口即可)。 其官网是: http://www.uploadify.com/ ,官方提供的示例服务端用的是PHP。 这里有一个Django使用的例子: http://dmyz.org/archives/350 总

很好 。。

呵呵,谢谢

非常好

....................

在unix网络编程中看到了关于TCP/IP的一些内容,我感觉还是写的不够。正在下载中,一定

下载地址呢

谢~~